SEO-аудит — это анализ сайта с целью проверки его соответствия требованиям поисковых систем. Процесс включает в себя оценку текущей позиции ресурса, описание действий, необходимых для увеличения целевых переходов, и др. Пробный технический аудит выполняется после полученной заявки от клиента для ознакомления. Для упрощения работы специалиста возможно использование опросного листа, позволяющего понять цели проекта, аудиторию, частоту обновлений сайта, особенности проводившейся ранее оптимизации.

Детальный SEO-аудит сайта.

Детальный SEO-аудит сайта.

Специфика первичного SEO-аудита

В течение пробного периода проводятся работы по детальному анализу ресурса. Процесс разделяется на 3 части, которые могут быть представлены посредством Google Slides.

- Контент. При работе с текстовым наполнением исследуются использованные ключевые слова. На этом этапе анализируются сайты конкурентов, просматриваются метаданные, карта и др.

- Технические характеристики. В эту часть входят индексирование, хостинг, выявление ошибок сканирования и др.

- Ссылки. В этой части анализируются профиль обратной связи, тактика роста и др.

Для проведения эффективного SEO-аудита необходим доступ к Google Analytics и к другим инструментам, а также к серверу. Кроме того, нужно иметь информацию о действующих аккаунтах компании-заказчика в социальных сетях и др.

Инструменты для аудита

Для того чтобы оптимизировать сайт онлайн, можно пользоваться сервисами на бесплатной или платной основе. Для SEO-аудита применяются такие инструменты, как Screaming Frog, DeepCrawl, Copyscape, Pingdom, Google Analytics и др. Выбор подходящего сервиса осуществляется в зависимости от возможностей, которые он предлагает, используемой линейки персональных компьютеров, например Mac или PC, а также от наличия или отсутствия доступа.

Применение DeepCrawl

Сервис сканирует сайт в течение 1 или 2 дней. Среди полученных результатов важно обращать внимание:

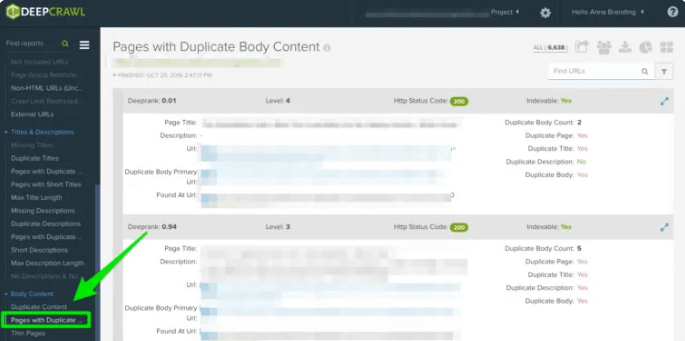

- на повторяющийся контент. Отчет Duplicate Pages отражает результат. В случае обнаружения повторяющегося контента необходимо переписывать или дорабатывать тексты на страницах. Кроме того, специалист добавляет тег [meta name=”robots” content=”noindex, nofollow”]. С помощью инструмента обнаруживаются следующие ошибки: повторяющиеся метазаголовки и метаописания, домены, некорректная разбивка на страницы, одинаковые тексты и др. Для исправления необходимо добавить тег canonical. Он сообщает Google предпочитаемый URL. Файл robots.txt запрещает некорректные адреса;

Выявление дублированного контента во время SEO-аудита.

Выявление дублированного контента во время SEO-аудита.

- пагинацию. Существуют 2 отчёта проверки. First Pages позволяет просмотреть постраничное разбиение. Для определения правильности пагинации можно выполнить ручное тестирование. Отчет Unlinked Pagination Pages показывает, как работает разбиение, позволяют ли rel = «next» и rel = «prev» переходить на следующую и предыдущую страницу. Для исправления ошибок целесообразно использовать несколько способов. При наличии возможности «просмотреть все» добавляется тег rel = «canonical». Стандартный тип разметки работает, когда все страницы открываются по отдельности. При использовании бесконечной прокрутки добавляется эквивалентный URL-адрес в Java S;

Обнаружение ошибок пагинации с помощью SEO-аудита.

Обнаружение ошибок пагинации с помощью SEO-аудита.

- максимальное перенаправление. Для выявления ошибок используется отчёт Max Redirections. Google останавливает перенаправления, если их более 5. Могут появляться следующие коды ответов: 301, 302, 400, 403, 404, 500. Первые 2 свидетельствуют о том, что всё исправно при условии существования 1 незацикленного редиректа. Последующие 3 кода показывают, что пользователи не попадают на страницу по определённым причинам. Последний касается ошибок сервера. Чтобы разрешить проблемы максимального перенаправления, необходимо удалить внутренние ссылки, ведущие на старые страницы, или отменить цепочку.

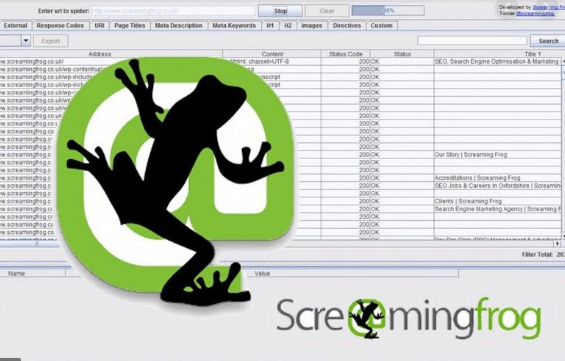

Обзор Screaming Frog

Сервис для проведения SEO-аудита.

Сервис для проведения SEO-аудита.

Сервис обходит несколько областей сайта за 1 раз. Необходимые показатели настраиваются в зависимости от размеров ресурса. Среди результатов проверки необходимо выделять:

- код Google Analytics и сниппет Google Tag Manager. Сервис определяет страницы, на которых нет кода. Для того чтобы его найти, необходимо перейти в Configuration и выбрать Custom, после этого добавить analytics.js в Filter 1 и поменять значение на Does not contain. Инструмент определяет также наличие Google Tag Manager. Чтобы найти сниппет, необходимо выполнить действия, аналогичные поиску кода, и добавить iframe src — «// www.googletagmanager.com/ со значением Does not contain;

- схему и индексирование. В процессе технического аудита выполняется проверка микроразметки, так как с помощью структурированных данных поисковик идентифицирует страницу. Для проверки нужно перейти в Custom и добавить itemtype = «http: // schema. .org / со значением Contain. Чтобы определить количество индексируемых страниц, нужно перейти в Directives — Filter — Index и просмотреть отсутствующие фрагменты кода. Устранить проблему можно посредством проверки robots.txt. Кроме того, необходимо точно убедиться в отправке SiteMap для ресурса клиента;

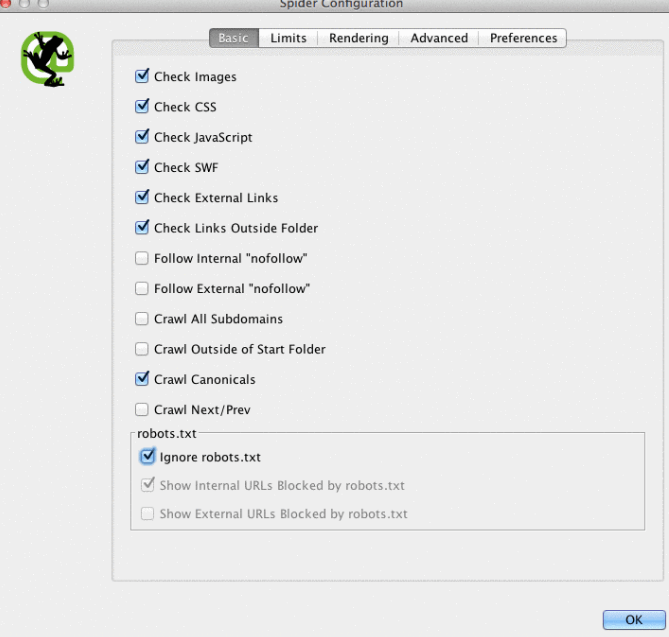

- Flash и JavaScript. Чтобы Google Chrome не заблокировал Flash из-за того, что сайт медленно загружается, нужно понять, используется ли он ресурсом. В рассматриваемом сервисе необходимо перейти в Spider Configuration, нажать на Check SWF и на вкладке Internal поставить соответствующий фильтр. Исправить ситуацию можно с помощью кода HTML 5. Язык программирования JavaScript используется на ресурсе только до момента выполнения блокировок в robots.txt. Проверка проводится в Spider Configuration. По результатам ставится соответствующий фильтр в Internal;

- Robots.txt. Этот файл блокирует контент, который не нужен поисковым системам, поскольку он бесполезен для индексации. Файл нужно обновлять так, чтобы он оказался в нижнем регистре. Все страницы типа disallow удаляются. При стандартных настройках сервиса он не загружает URL страниц, которые запрещены в файле. Их можно посмотреть на вкладке Response Codes и отфильтровать. Для ресурсов, имеющих несколько поддоменов, создаются отдельные robots.txt. В файле должен быть указан SiteMap;

Использование файла robots.txt во время SEO-аудита.

Использование файла robots.txt во время SEO-аудита.

- ошибки сканирования. Для проведения их поиска необходимо перейти в Bulk Reports, найти в списке Response Codes и экспортировать отчёты. Для устранения проблем нужно действовать совместно с разработчиками. Предварительно создаётся резервная копия ресурса. Кроме того, выполняется удаление какого-либо перенаправления и внешней или внутренней ссылки. Код 404 позволяет отслеживать адреса с помощью Google Analytics;

- цепочки редиректов и ссылки. Они могут замедлять процесс загрузки страниц. В разделе Redirect Chains просматривается путь сканирования перенаправлений. Относительно ссылок в момент клика пользователь может увидеть ошибку 404. Для поиска неисправностей в сервисе после окончания тестирования осуществляется переход в Bulk Export и в All Outlinks. Сортировка по URL позволяет определять страницы, выдающие ошибку;

- URL-адреса. В процессе их проверки удаляются символы, которых не должно быть, например знаки равенства. Для упрощения можно убирать лишние слеши. Чтобы выполнить всё это, необходимо добавить тег canonical на главную страницу, произвести обновление параметров посредством Google Search Console и прописать запрет на дублирование адресов в robots.txt.

Применение Google Search Console

Сервис для детального SEO-аудита.

Сервис для детального SEO-аудита.

Работа с основным доменом. Его установление для поисковых систем обеспечивает точность переходов. Благодаря основному домену можно убедиться, что все ссылки ведут на 1 ресурс. В Google Search Console выбирается значок с шестеренкой и определяется основной URL.

Настройка обратных ссылок. Google объявил, что алгоритм Penguin функционирует в реальном времени. В связи с этим важно, чтобы обратные ссылки соответствовали требованиям поисковой системы. Для устранения ошибок бесплатного аудита необходимо в Google Search Console отсортировать результаты в Linked Pages, связаться с сайтами, удалить ссылки, ведущие на ресурс с других сайтов. При этом следует оставлять полезные ссылки.

Подбор ключевых слов. При работе с ними важно знать потребности целевой аудитории. Первоначально просматриваются результаты выдачи по запросам, с которых клиент уже получает трафик. В сервисе Google Search Console предусмотрен раздел Search Analytics. В нём находятся ключевые слова, приводящие к кликам.

Работа с картой сайта. Сканированию сайтов роботами поисковых систем способствуют файлы SiteMap. При их создании не включаются параметры URL и неиндексируемых страниц. В случае, когда у сайта разные поддомены для персональных компьютеров и мобильных устройств, в карту добавляется rel = «alternate». В сервисе используется раздел SiteMap, позволяющий сравнивать проиндексированные URL. Поиск старых перенаправленных страниц осуществляется вручную, после чего они удаляются.

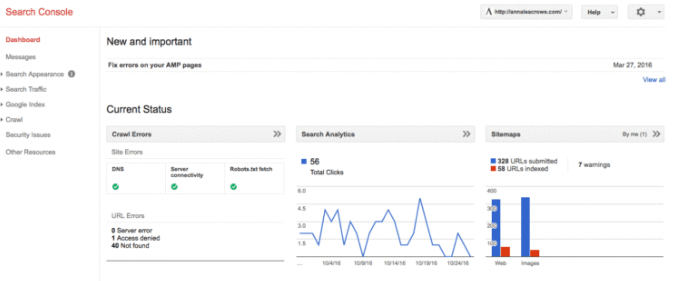

Выполнение сканирования. Возникающие ошибки препятствуют ранжированию сайта. Для выполнения аудита необходимо перейти в Crawl Errors. Проверка ошибок выполняется вручную. Кроме того, анализируется статистика сканирования контента со средним временем загрузки в Google Analytics. Так определяется взаимосвязь между временем на загрузку и просмотренными страницами в течение 1 дня.

Работа со структурированными данными. В разделе Structured Data можно ознакомиться со схемой разметки ресурса. Таким способом определяются страницы, имеющие структурированные данные, которым требуется доработка. Сервис сообщает, какой компонент отсутствует во время тестирования. С опорой на коды ошибок нужно переписать схему посредством текстового редактора.

Обзор Google Analytics

Действия с представлениями. Для внесения изменений без затрагивания данных можно установить 3 представления, среди которых отчёты, тестирование и мастер. Это делается в разделе Admin — View Settings. В обязательном порядке проверяется Bot Filtering, в котором включается возможность отслеживания поиска по ресурсу. Представления связываются с Google Search Console и AdWords.

Настройка фильтров. Чтобы исключить получение ложного трафика, нужно добавить в них IP-адреса. Для этого выполняется переход в Admin — View — Filters и устанавливаются настройки Exclude — traffic from the IP addresses — that are equal to.

Работа с кодом. Поиск может выполняться в ручном формате. При наличии кода отслеживание проходит в реальном времени. Для проверки выполняются переход на сайт клиента и несколько кликов. В рассматриваемом сервисе в разделе Real-Time — Locations отражается местоположение. Если нет выполнения кода, проверяются его фрагменты. При этом используются только строчные буквы.

Действия по индексированию. При выполнении SEO-аудита возможно сравнение индексации в Google Search Console и в Google Analytics. В первом сервисе открывается вкладка Advanced из раздела Google Index. Во втором — Landing Page в Acquisition. Номера сравниваются друг с другом. Если они значительно различаются между собой, то только некоторые страницы получают органический трафик.

Просмотр индексации сайта в процессе SEO-аудита.

Просмотр индексации сайта в процессе SEO-аудита.

Разработка теггинг-кампании. Для проверки её корректности настраивается отслеживание событий в случае, если клиент использует видеоролики, а также мобильную рекламу. Кроме того, необходимо грамотно разработать стратегию тегов.

Поиск ключевых слов. Сервис может применяться для определения запросов с высокой эффективностью. Поиск ключевых слов осуществляется в разделе Behavior — Site Search — Search Terms. Найденные запросы используются для создания нового сегмента в сервисе и для определения страниц, которые уже ранжируются по ним.

Проведение ручной проверки

Такой анализ сайта можно провести при помощи нескольких инструментов: ресурса You Get Signal, сервисов Pingdom и Google Analytics и др. Чтобы распознать подключение контента к запросам поиска, нужно провести быструю проверку кэширования топовых страниц поисковой системой Google. Если во время проверки обнаруживаются ошибки, необходимо проанализировать работу сервера клиента. Важной задачей при проведении аудита является анализ программного обеспечения, которое связано с ресурсом. К частым проблемам хостинга относятся следующие: медленная скорость сайта и некорректный LTD.